Компанія IBM запускає інструмент, який буде аналізувати, як і чому алгоритми ШІ (штучного інтелекту) приймають рішення, і все це в режимі реального часу.

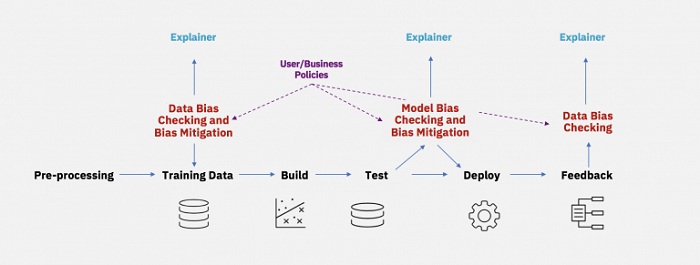

«Ми раді анонсувати ШІ Fairness 360 (AIF360), комплексний інструментарій метрик з відкритим вихідним кодом для перевірки небажаного зсуву в наборах даних і моделях машинного навчання, а також сучасні алгоритми для пом’якшення такого зміщення. Ми запрошуємо вас використовувати його й вносити в нього зміни, щоб допомогти підвищити довіру до ШІ й зробити світ справедливішим для всіх».

Зараз зростає занепокоєння, що алгоритми, які використовуються як технічними гігантами, так і дрібнішими підприємствами, не завжди точні в процесі прийняття рішень. Наприклад, нещодавно система розпізнавання не змогла ідентифікувати обличчя темношкірої людини. А оскільки прийняття рішень усе частіше відбувається в автоматичному режимі в таких напрямках, як поліцейська діяльність, страхування або отримання інформація про те, що люди переглядають в Інтернеті, наслідки при неправильному рішенні можуть бути плачевними.

Програмне забезпечення для хмарних обчислень IBM буде з відкритим вихідним кодом і буде працювати з різними часто використовуваними структурами для побудови алгоритмів.

Користувачі зможуть побачити за допомогою візуальної панелі, яким чином їх алгоритми приймають рішення і які фактори використовуються при складанні остаточних рекомендацій.

«Ми даємо нові можливості у вигляді прозорості й контролю підприємствам, які використовують ШІ та стикаються з великим потенційним ризиком від будь-якого помилкового прийнятого рішення», – сказав Девід Кенні (David Kenny), старший віце-президент Cognitive Solutions (департамент IBM Research).

Цією проблемою займається не тільки компанія IBM. Наприклад, минулого тижня Google запустив інструмент «що-якщо», також розроблений, щоб допомогти користувачам зрозуміти, як працюють їхні моделі машинного навчання. Однак інструмент Google не працює в режимі реального часу (на відміну від Fairness 360) – дані можуть бути використані для побудови загальної картини тільки через деякий час.

У травні в Microsoft заявили, що вони працюють над інструментарієм виявлення «зміщення» в алгоритмах, а у Facebook заявили, що вже тестують інструмент, що допомагає визначити, чи є алгоритм упередженим у прийнятті рішень.

Зростає дискусія навколо штучного інтелекту та етики. У 2015 році Google вже приносив свої вибачення за те, що їх алгоритм для фотографій Google Photos ідентифікував афроамериканців як горил.

Джерело: bbc